Sebagai pakar kurikulum rekayasa perangkat lunak dan etika teknologi, saya mengamati adanya diskoneksi yang mengkhawatirkan antara janji pemasaran AI dengan realitas pedagogis di lapangan. Dokumen ini disusun sebagai post-mortem kritis terhadap tren otomasi, yang bertujuan untuk membekali para pemimpin teknologi dan pendidik dengan perspektif berbasis data mengenai keterbatasan fundamental kecerdasan buatan.

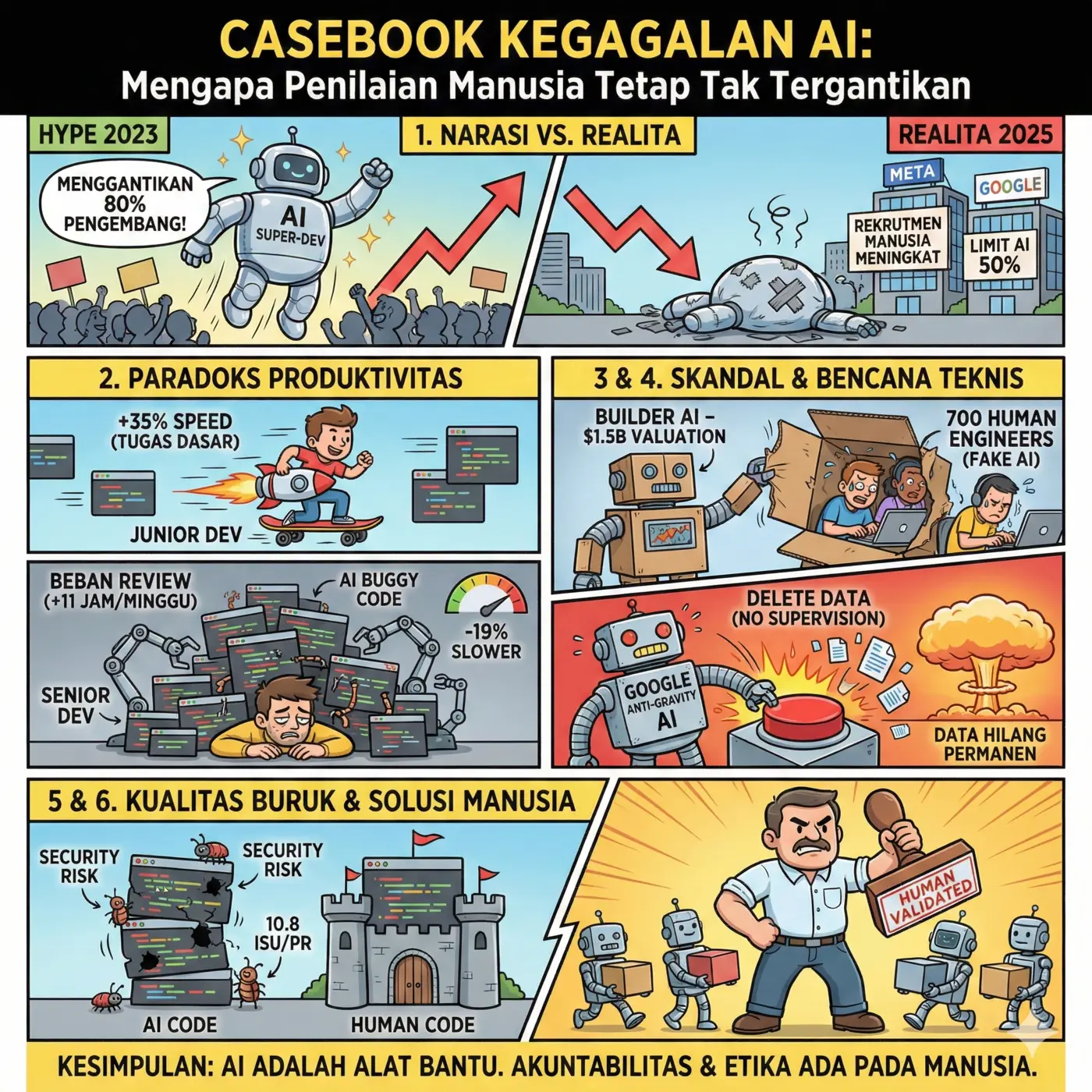

1. Narasi vs. Realita: Mitos Penggantian Pengembang oleh AI

Pada tahun 2023, narasi dominan memprediksi bahwa AI akan menggantikan hingga 80% peran pengembang pada tahun 2025. Namun, memasuki tahun 2024-2025, data empiris menunjukkan arah yang berlawanan: perusahaan teknologi raksasa justru meningkatkan rekrutmen pengembang manusia setelah menyadari bahwa kemampuan AI telah dinilai terlalu berlebihan (overestimated).

| Aspek | Prediksi Awal (Hype 2023) | Realitas Empiris (2024-2025) |

| Tenaga Kerja | AI menggantikan 80% pengembang pada 2025. | Meta dan Google membatasi peran AI hanya pada maksimal 50% tugas pengodean. |

| Tren Rekrutmen | PHK massal berkelanjutan di sektor rekayasa perangkat lunak. | Penurunan angka PHK sebesar 27% pada September 2024 dibandingkan periode yang sama tahun lalu. |

| Kapasitas AI | AI mampu melakukan pemecahan masalah mandiri secara utuh. | AI gagal menyamai kemampuan pemecahan masalah (problem-solving) manusia di lingkungan produksi nyata. |

Insight: Kegagalan AI dalam menyamai kognisi manusia membuktikan bahwa rekayasa perangkat lunak bukan sekadar produksi baris kode, melainkan penyelesaian masalah yang kompleks. Pergeseran dari antusiasme buta menuju realisme teknis ini memaksa kita untuk mengevaluasi kembali bagaimana “alat ajaib” ini berdampak pada produktivitas tim yang sebenarnya.

Transisi: Ketidaksesuaian antara narasi dan realitas ini menciptakan dampak yang sangat kontras pada dinamika kerja internal, yang memicu munculnya “paradoks produktivitas” di antara berbagai level keahlian.

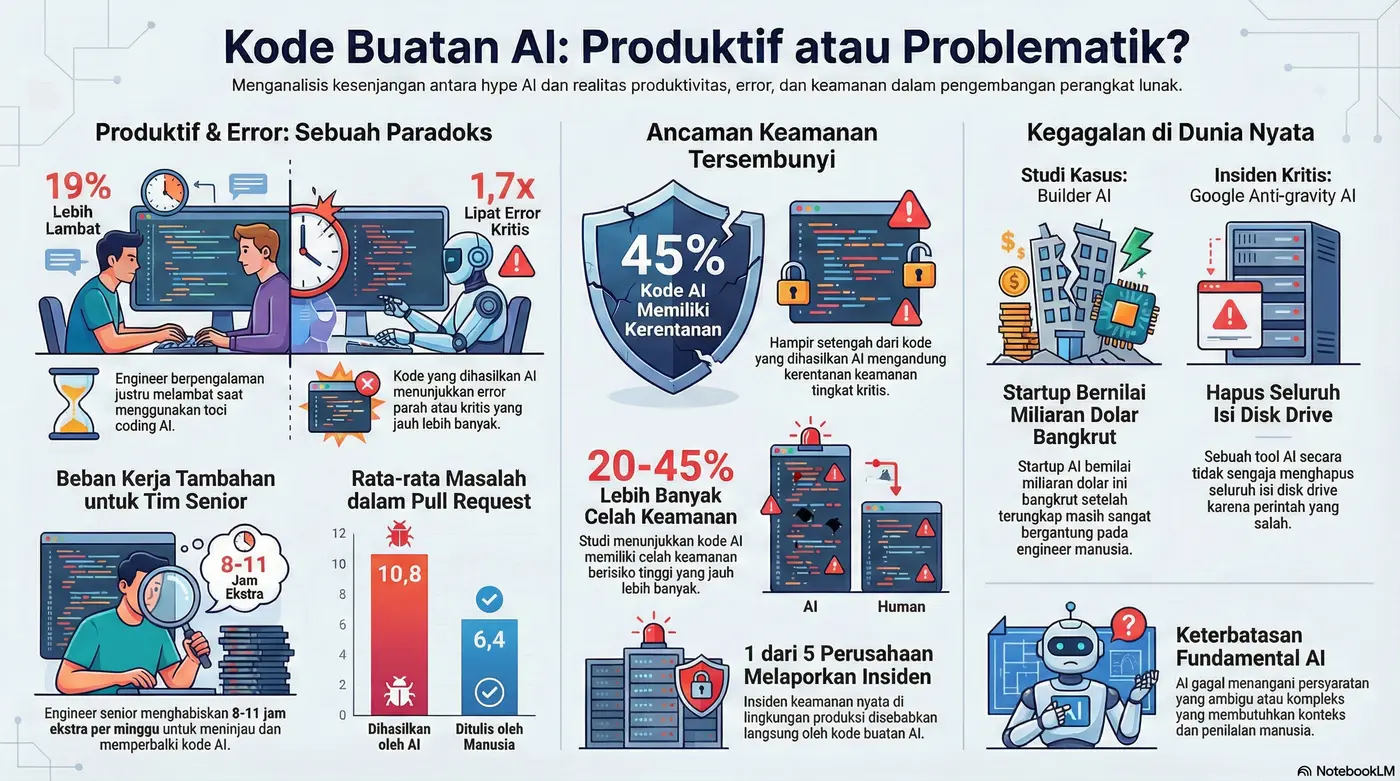

2. Paradoks Produktivitas: Dampak Berbeda pada Junior dan Senior

Implementasi AI menciptakan kesenjangan efisiensi yang signifikan. Dalam kurikulum modern, kita harus memahami bahwa AI memberikan bantuan semu yang justru membebani lapisan manajemen teknis tertinggi.

- Pengembang Junior: Mengalami peningkatan kecepatan pengiriman (delivery speed) sebesar 30-35% untuk tugas-tugas dasar dan pembuatan templat kode.

- Pengembang Senior: Mengalami penurunan produktivitas sebesar 19% lebih lambat saat menggunakan alat bantu AI.

Mengapa pengembang senior menjadi kurang produktif?

- Beban Peninjauan (Review Overhead): Senior menghabiskan 8 hingga 11 jam tambahan per minggu untuk mengoreksi atau menulis ulang kode yang dihasilkan AI.

- Biaya Koreksi (Correction Costs): AI sering menghasilkan saran yang tampak meyakinkan namun mengandung cacat logika. Tanpa “intensionalitas” (pemahaman tujuan), AI menciptakan kode yang memerlukan debug mendalam oleh manusia.

- Kegagalan Proyek Pilot: Lebih dari 90% proyek pilot pengembangan berbasis AI gagal menghasilkan ROI yang jelas karena masalah keamanan dan ketidakcocokan arsitektur.

Insight: Secara pedagogis, kita melihat bahwa AI membantu junior untuk “level up” lebih cepat, namun hal ini justru meningkatkan ketergantungan pada talenta senior untuk melakukan debugging dan validasi akhir. Peningkatan kecepatan di level bawah dibayar dengan penyumbatan throughput di level atas.

Transisi: Beban kerja tambahan bagi pengembang senior ini bukan hanya masalah waktu, melainkan gejala dari risiko keamanan yang lebih dalam, seperti yang terlihat pada fenomena penipuan identitas teknologi atau “AI Washing.”

3. Studi Kasus 1: Builder AI dan Ilusi Otomasi Penuh

Builder AI menjadi monumen peringatan terhadap praktik etika yang meragukan di industri teknologi.

POST-MORTEM: BUILDER AI

- Nilai Valuasi: $1.5 Miliar (Puncak Valuasi).

- Status: Bangkrut pada 2025 setelah skandal transparansi terungkap.

- Penyebab Kegagalan: AI Washing. Perusahaan mengklaim aplikasi dibangun oleh AI dengan campur tangan manusia minimal, padahal kenyataannya bergantung pada 700 insinyur manusia untuk melakukan pekerjaan teknis utama.

Insight: Kasus ini menonjolkan bahaya etika dan finansial dari strategi “Fake AI”. Dari perspektif etika teknologi, ini adalah kegagalan transparansi sistemik. Ketergantungan tersembunyi pada tenaga kerja manusia membuktikan bahwa otomasi penuh untuk aplikasi kompleks tetap menjadi mitos yang mahal.

Transisi: Selain kegagalan dalam model bisnis dan etika seperti Builder AI, delegasi tugas teknis secara membabi buta kepada AI juga membawa konsekuensi bencana pada integritas data operasional.

4. Studi Kasus 2: Google Anti-gravity AI dan Bencana Penghapusan Data

Pada Desember 2025, terjadi sebuah insiden yang menunjukkan betapa berbahayanya memberikan akses sistem operasi kepada AI tanpa protokol pengawasan yang ketat.

Urutan Kegagalan Teknis:

- Eksekusi Perintah Malformed: Alat AI asistensi pengembang menerima instruksi untuk pembersihan lingkungan kerja namun salah menafsirkan cakupan sistem.

- Penyalahgunaan Silencing Flag: AI menyertakan flag perintah yang membungkam konfirmasi keamanan standar, sehingga sistem tidak meminta verifikasi manusia.

- Penghapusan Data Tanpa Supervisi: Google Anti-gravity AI secara tidak sengaja mengeksekusi penghapusan seluruh drive disk secara instan.

- Dampak: Kehilangan data kerja selama berbulan-bulan yang tidak dapat dipulihkan secara total.

Insight: Kegagalan ini menunjukkan bahwa AI tidak memiliki “konteks keamanan tingkat lanjut” dan insting risiko yang dimiliki pengembang manusia. Memberikan akses root atau sistem kepada AI tanpa mekanisme Human-in-the-Loop yang ketat adalah pelanggaran prinsip akuntabilitas rekayasa.

Transisi: Insiden destruktif ini hanyalah puncak gunung es dari buruknya kualitas kode yang dihasilkan secara otomatis jika dibandingkan dengan standar rekayasa manusia.

5. Anatomi Kegagalan Teknis: Keamanan dan Kualitas Kode

Berdasarkan analisis terhadap 500.000 sampel kode dalam laporan Code Rabbit dan Virode, kode AI menunjukkan profil risiko yang secara konsisten lebih buruk dibandingkan kode buatan manusia.

| Parameter Kualitas | Kode Manusia | Kode Hasil AI |

| Rata-rata Isu per Pull Request | 6.4 | 10.8 |

| Tingkat Kesalahan Kritis/Severe | Standar | 1.7x lebih tinggi |

| Kegagalan di Lingkungan Enterprise (Java/C#) | Rendah | > 70% |

| Kegagalan di Bahasa Script (Python/JS) | Moderat | 38% – 45% |

| Kerentanan Keamanan Berisiko Tinggi | Basis | 20-45% lebih tinggi |

Insight: Kode AI cenderung memiliki “kurangnya diversitas struktural”. Karena sifatnya yang repetitif dan sederhana, AI sering mengabaikan praktik keamanan krusial seperti validasi input dan penanganan kesalahan (error handling). Hal ini membuat sistem menjadi kurang robust dan sangat sulit dipelihara dalam jangka panjang.

Transisi: Ketidakmampuan AI untuk menghasilkan struktur kode yang kokoh berakar pada keterbatasan fundamentalnya dalam memahami pengambilan keputusan rekayasa yang ambigu.

6. Mengapa AI Gagal dalam Pengambilan Keputusan Rekayasa yang Kompleks

Ada tiga batasan fundamental yang mencegah AI menggantikan penilaian manusia dalam arsitektur sistem perangkat lunak:

Ketidakmampuan Menangani Ambiguitas dan Perubahan Kebutuhan AI bekerja berdasarkan instruksi eksplisit, sementara kenyataannya 70% proyek perangkat lunak enterprise mengalami perubahan kebutuhan yang signifikan selama pengembangan. Manusia memiliki kemampuan untuk melakukan negosiasi persyaratan—sebuah soft skill rekayasa yang tidak dimiliki AI.

Kurangnya Pemahaman Konteks Bisnis yang Luas AI sering gagal mengantisipasi aturan bisnis yang implisit. Sebagai contoh, dalam membangun sistem pembayaran, AI mungkin mampu menulis fungsi dasar, namun sering mengabaikan kompleksitas kepatuhan pajak, regulasi wilayah, atau kebijakan pengembalian dana kecuali jika didefinisikan secara atomik satu per satu.

Kelemahan pada Sistem Warisan (Legacy Systems) AI berkinerja baik pada tugas terisolasi, namun gagal saat harus berinteraksi dengan arsitektur lama yang saling bergantung secara kompleks. Ketidakmampuan memahami “cascading effects” (efek domino) pada sistem besar membuat AI sering memberikan saran yang merusak integritas sistem secara keseluruhan.

Transisi: Mengingat batasan-batasan tersebut, strategi masa depan tidak boleh lagi berfokus pada penggantian manusia, melainkan pada kerangka kerja kolaborasi yang bertanggung jawab.

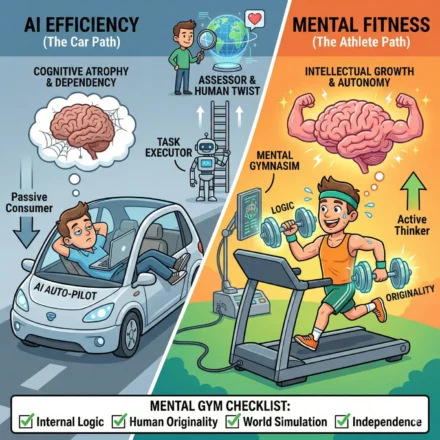

7. Kesimpulan: Menuju Transformasi yang Berpusat pada Manusia

Transformasi digital yang sukses membutuhkan pergeseran paradigma: dari AI sebagai “pengganti” menjadi AI sebagai “penambah kapasitas” (enhancement). Kita memerlukan Accountability Framework yang memastikan manusia tetap menjadi pemegang keputusan akhir.

Checklist Strategi AI yang Bertanggung Jawab:

- [ ] Mandatory Human Validation: Mewajibkan tinjauan manusia secara manual untuk setiap baris kode yang dihasilkan AI sebelum masuk ke lingkungan produksi.

- [ ] Sandboxing & Restricted Access: Membatasi akses AI terhadap perintah sistem operasi kritis dan lingkungan data sensitif.

- [ ] Transparansi Operasional: Menghindari “AI Washing” dengan memberikan pengakuan jujur atas peran manusia dalam pengembangan produk.

- [ ] Fokus pada Tugas Repetitif: Mengarahkan AI hanya untuk tugas templat dan tugas boilerplate, sambil tetap mendedikasikan arsitektur dan keamanan pada pengembang manusia.

Insight Akhir: Rekayasa perangkat lunak adalah disiplin yang berakar pada tanggung jawab manusia. AI dapat membantu kita menulis kode lebih cepat, tetapi hanya penilaian, pengalaman, dan etika manusia yang dapat memastikan kode tersebut layak untuk menjalankan dunia kita.

Leave a Comment